サーチコンソールの「インデックスされない問題」を解決するためにいろいろ調べていると、robots.txtファイルを編集するという機会に出くわしました。

けーさん

けーさんrobots.txtって何?聞いたことないなぁ。

そこで今回は、robots.txtとは何なのか、その役割と編集方法、注意点などを紹介します。

robots.txtとは?

robots.txtとは、Googleさんの説明によると、

robots.txt ファイルとは、検索エンジンのクローラに対して、サイトのどの URL にアクセスしてよいかを伝えるものです。

by Google検索セントラル

はるこ

はるこrobots.txtによって、検索エンジンのクローラーを限定したり、アクセスして欲しくないページをクロールさせなくできると言う事ね。

wordpressでは何もしなくても、このrobots.txtはルートディレクトリ直下に作成されています。

robots.txtを確認するには

自身のサイトのrobots.txtを確認するには、サイトURLに「robots.txt」を追加することで確認できます。

*例 https://ksanhonsan.com/robots.txt

確認してみると、次のように表示されます。

XMLサイトマップなどのプラグインをインストールしている場合は、若干表示は異なりますが、大体似たような内容です。

robots.txtファイルはどこにあるのか?

ところで、robots.txtはどこにあるんでしょうか?

ファイルを設置するのはルートディレクトリ直下であるのは分かってましたが、

けーさん

けーさん気になったので、XseverのファイルマネージャーやFTPソフトで探しましたが、見つかりませんでした。

\Xserverの申し込みはこちらから/

実は、robots.txtファイルは仮想ファイル(この呼び方が正しいかどうかは分かりませんが)で、アクセスがあれば表示される性格のファイルだそうです。なのでファイルマネージャ等から実態を確認する事はできません。

robots.txtの作成と設置

はじめにお断りしておきます。

基本的にrobots.txtの編集は、サイトページ数が膨大な大手の企業サイトなどでもない限り個人ブログではまず触る必要はありません。

また、編集するにはある程度のスキルが必要ですし、ミスにより全くインデックス登録されなくなるような事態も考えられます。

なので、取り扱いはあくまで自己責任でお願いします。

robots.txtの作成

robots.txtをカスタマイズするには、新しくrobots.txtファイルを作成する必要があります。

書き込むエディタは、メモ帳(Notepad)やサクラエディタなどのテキストエディタでOKです。(wordやexcelは使わない方が良い。)

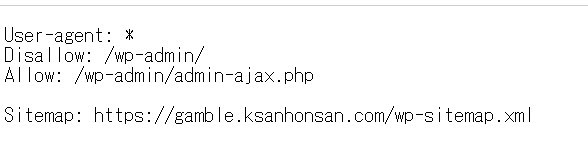

wordpressのデフォルトのrobots.txtの構文は、

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://gamble.ksanhonsan.com/wp-sitemap.xmlこのようになっています。

ここでは、robots.txtの詳しい記述方法は省略します。Allowは「許可」、Disallowは「拒否」だと言うくらい覚えておけば大丈夫です。

これに、例えば「Disallow: /*?PageSpeed=noscript」を追加してみますと、

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /*?PageSpeed=noscript

Sitemap: https://gamble.ksanhonsan.com/wp-sitemap.xml上記のようになります。

上記の構文をメモ帳で書いて保存します。保存するファイル名は必ずrobots.txtにします。それ以外のファイル名だと機能しません。

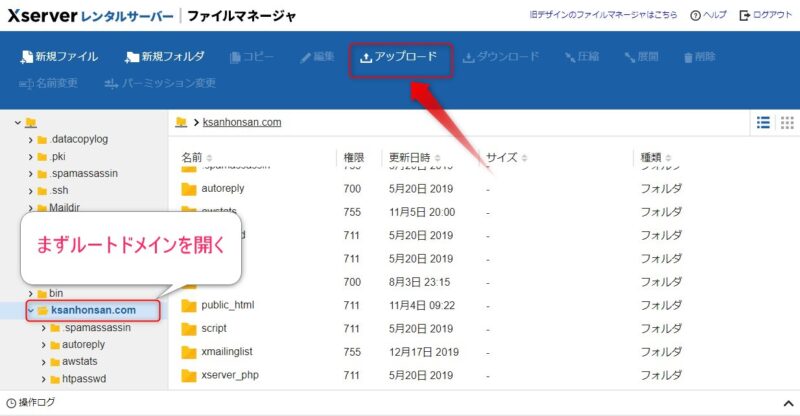

robots.txtの設置(アップロード)

出来上がったrobots.txtファイルをサーバーにアップロードします。ファイルのアップロードはFTPソフトやファイルマネージャーで行います。

ここではXserverのファイルマネージャーを例に説明します。

Xserverのファイルマネージャーを開いたら、ルートドメインのフォルダを開きます。

開いたら上部メニューから「アップロード」を選択クリック、

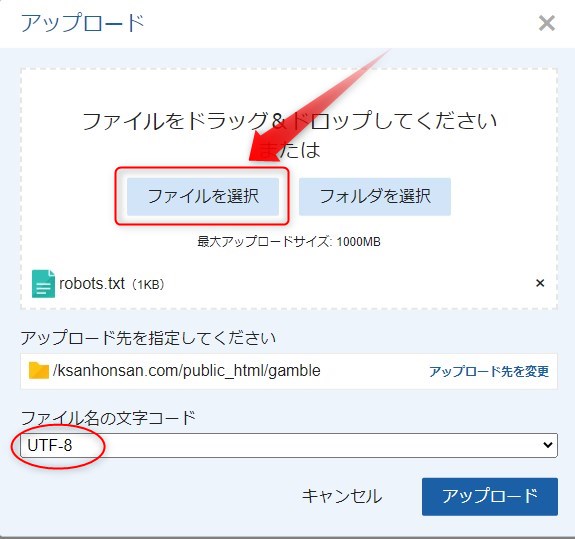

上図のような画面が出たら、ファイルを選択ボタンからrobots.txtを指定し、アップロードをクリックします。

*この時ファイル名の文字コードは「UTF-8」であることを確認しておいてください。

これでrobots.txtファイルはルートディレクトリにアップロードされます。

robots.txtの動作確認

robots.txtがうまく動作するかどうかを確認しておきましょう。

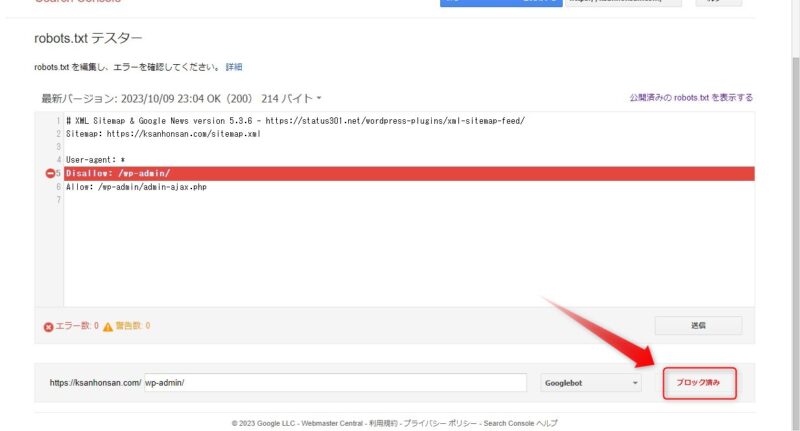

確認するには、サーチコンソールのrobots.txtテスターを使います。

テスターを開いたら、「プロパティを選択してください」のプルダウンメニューからrobots.txtを設置するURLを選択してください。

上図の画面に切り替わると、robots.txtの構文にエラーがあるかどうか確認できます。

ここで構文エラーがあれば修正できます。

続いて、DisallowでブロックしたURLがうまく機能しているかどうかを下段の「URLがブロックされているかどうかをテストするには、URLを入力してください。」のところにURLを記入して、右側のテストボタンを押します。

すると、Disallowが正常に動作している場合はブロック済み、Allowの場合は許可済みと表示されます。

はるこ

はることころで、robots.txtはできたけど、従来のwordpressデフォルトのrobots.txtはどうなるの?

けーさん

けーさんクローラーは新しく設定したrobots.txtを優先しますのでデフォルトのrobots.txtは無視されます。重複の心配はありません。

robots.txtの注意点

robots.txtを設定する上での注意点は以下です。

- robots.txtが反映されるまでにタイムラグがある。

- 構文ミスにより全くインデックスされないこともある。

- SEO的な効果はほぼない。

- クロールは拒否するが、ユーザーはアクセスできる。

- アドレスバーにURLを入力すれば、robots.txtの内容が外部に見られる。

はるこ

はるこrobots.txtはSEO的な効果は望めないけど、構文ミスによってインデックスされないこともあるので気を付けて。

まとめ

もともとは、サーチコンソールからの「重複しています。」の警告メールがきっかけで、URLに/?PageSpeed=noscriptが付いたページをクロールさせないために調べることとなったrobots.txtです。

調べていく内に、/?PageSpeed=noscriptは無視していい事が分かり、さらにrobots.txtの目的は無駄なクロールを減らしサーバーの負荷を軽減するためのものだと言う事が分かりました。

なので、月間PVが数千と少なく、サイトページも数百程度のブログにはrobots.txtを編集する必要などなさそうです。

ただこれをきっかけに、robots.txtの存在と意味を学べたことはまんざら無駄ではなかったと思っています。

「robots.txtとは何か?」と疑問に思っている方は参考にしてください。

けーさん

けーさん繰り返しになりますが、robots.txtの編集はあくまでも自己責任でお願いしますね。

今回は以上です。

それでは

コメント